Inhaltsverzeichnis

Das Problem mit dem manuellen Umzug der Daten

Die manuelle Datenextraktion ist sehr zeitaufwendig und nervenraubend. Du klickst und lädst Excel-Dateien von Universal Analytics herunter, eine nach der anderen. Das dauert ewig, und es kann durchaus dazu kommen, dass du einige wichtige Dinge übersiehst. Ein Umzug mit unvollständigen Daten könnte zur Verzerrung deiner Auswertungen und Statistiken führen und schließlich zu falschen Optimierungsmaßnahmen.

Warum ist der manuelle Umzug also nicht die beste Idee?

- Zu langsam: Der manuelle Umzug ist sehr zeitintensiv, man kann Stunden oder sogar Tage verbringen und bekommt trotzdem nicht alles, was man braucht.

- Fehlende Teile: Wichtige Teile deiner Daten können durch Konzentrations- und Übertragungsfehler verloren gehen.

- Eingeschränkte Analyse: Mit Excel kannst du nicht ohne Weiteres umfangreiche Analysen durchführen oder komplexe Abfragen an deinen Daten vornehmen.

- Keine gemeinsame Bearbeitung: Es gibt zwar eine Browser-Lösung von Excel, jedoch mit weniger Funktionen. Dadurch ist das gemeinsame Bearbeiten der Daten erschwert.

Einrichten und Verwenden des Skripts: Schritt-für-Schritt

Schritt 1: Richte dein BigQuery-Konto ein

Stelle zunächst sicher, dass du ein Google Cloud-Konto mit BigQuery hast. BigQuery ist ein Analytics-Webservice von Google, der auf der Google Cloud Platform produziert wird und ein vollständig von Google verwaltetes, serverloses Data Warehouse zur Verfügung stellt. Wähle anschließend ein Projekt mit einem Datensatz an einem Ort aus, der für den Export geeignet ist und den du mit anderen Daten verwenden kannst. Behalte sie im Hinterkopf und verwende die nächsten Schritte im ausgewählten Projekt. Dies wird das neue Zuhause für deine Universal Analytics-Daten sein.

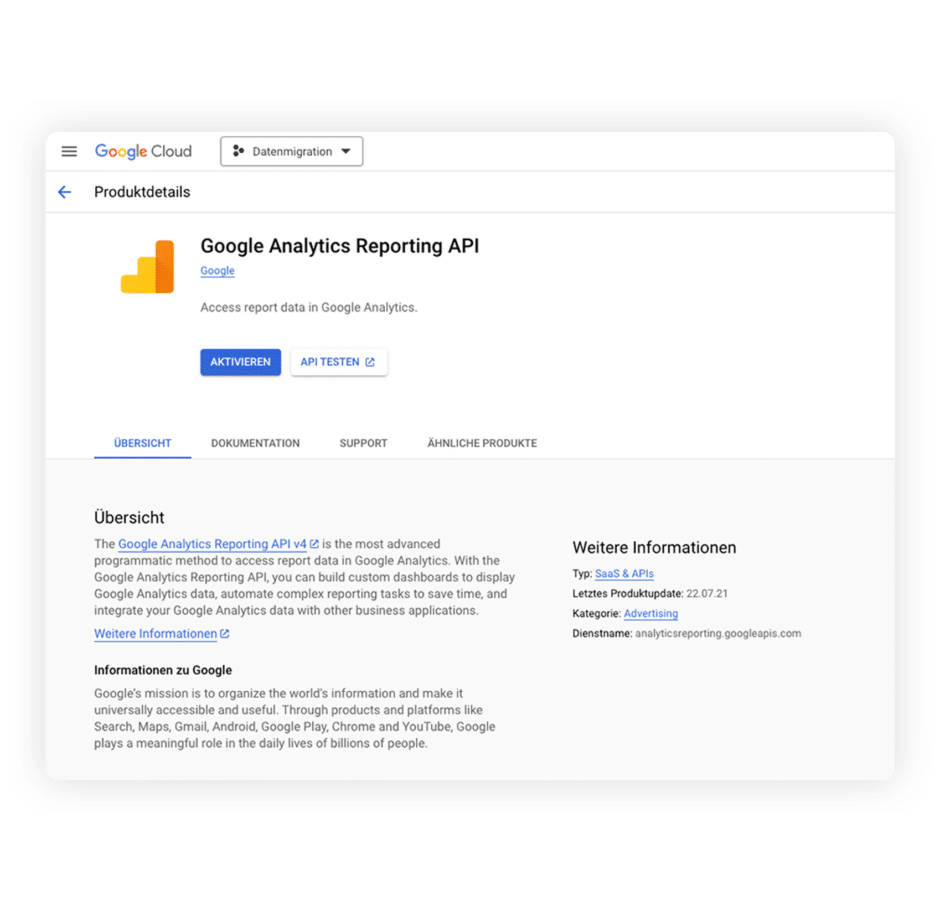

Schritt 2: Aktiviere die Google Analytics Reporting API

Damit das Skript mit Google Analytics kommunizieren kann, musst du die entsprechende API aktivieren:

- Gehe direkt auf diesen Link, um auf die Google Analytics Reporting API in der Google Cloud Console zuzugreifen.

- Erstelle ein Projekt für den Umzug der Daten (z.B. “Datenmigration”)

- Klicke darauf, um sie zu aktivieren. Mit dieser Aktion gibst du deinem Skript einen Schlüssel für den Zugriff auf die Analytics-Daten.

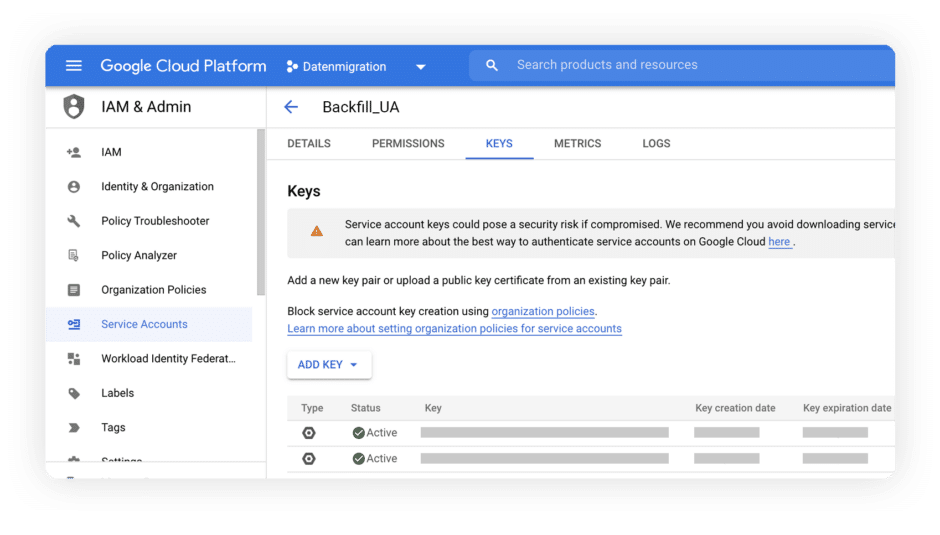

Schritt 3: Erstellen eines Dienstkontos und Herunterladen des JSON-Schlüssels

Verwende ein Dienstkonto für den sicheren Zugriff auf BigQuery und Analytics:

- Navigiere in der Google Cloud Console zu „IAM & Admin“ > „Dienstkonten“.

- Erstelle entweder ein neues Dienstkonto oder verwende ein bestehendes und stelle sicher, dass es über „Eigentümer“-Zugriff verfügt.

- Gehe in den Details des Dienstkontos zum Abschnitt „Schlüssel“.

- Klicke auf „Schlüssel hinzufügen“ und erstelle einen neuen Schlüssel. Wähle JSON als Schlüsseltyp und lade ihn herunter.

Anmerkung: Der JSON-Schlüssel ist von entscheidender Bedeutung und sollte geheim gehalten werden – er ist wie das Passwort für dein Skript für den Zugriff auf deine Daten.

Schritt 4: Zugriff auf Google Analytics gewähren

Als Nächstes benötigt dein Dienstkonto die Erlaubnis, Daten von Universal Analytics abzurufen:

- Füge in deinem Google Analytics-Konto die E-Mail des Dienstkontos (zu finden in den Details des Dienstkontos) zum Property Access Management hinzu. Ein „Viewer“-Zugriff ist ausreichend.

Schritt 5: Zugriff auf das Skript und dessen Konfiguration

Um zu beginnen, musst du auf das Skript zugreifen. Gehe zu GitHub und navigiere zum Repository Universal-Analytics-to-BigQuery. Hier findest du das Skript mit dem Namen backfill-UA.py. Dies ist das Skript, das du für die Migration deiner Daten verwenden kannst.

Ausfüllen der Konfiguration

Sobald du das Skript aufgerufen hast, musst du es mit deinen spezifischen Details konfigurieren. Suche den Abschnitt im Skript, der mit „Konfigurationsvariablen für Google Analytics und BigQuery“ beginnt. Hier findest du eine Aufschlüsselung der Angaben, die du machen musst:

- SCOPES: Dies sollte bereits auf [‚https://www.googleapis.com/auth/analytics.readonly‚] eingestellt sein und muss normalerweise nicht geändert werden.

- KEY_FILE_LOCATION: Gebe den Dateipfad an, in dem sich deine heruntergeladene JSON-Schlüsseldatei befindet. Dies ist der Schlüssel, den du zuvor für dein Dienstkonto erstellt hast.

- VIEW_ID: Gebe hier deine Google Analytics View ID ein. Diese findest du in deinem Google Analytics-Konto unter Admin → Ansichtseinstellungen.

- BIGQUERY_PROJECT: Gebe die ID deines Google Cloud-Projekts ein. Dies ist der Ort, an dem sich BigQuery befindet (auffindbar unter BigQuery > Projektdetails).

- BIGQUERY_DATASET: Gebe den Namen deines BigQuery-Datensatzes ein, in dem du die Daten speichern möchtest.

- BIGQUERY_TABLE: Gebe abschließend den Namen der BigQuery-Tabelle ein, in der deine Daten gespeichert werden sollen. Wenn sie nicht existiert, wird sie erstellt.

Achtung: Achte darauf, dass du diese Angaben korrekt eingibst, damit das Skript ordnungsgemäß funktioniert. Hier ist ein Beispiel:

# Configuration variables for Google Analytics and BigQuery

SCOPES = [‘https://www.googleapis.com/auth/analytics.readonly']

KEY_FILE_LOCATION = ‘/content/ga4-awz-a6942c278eef.json’ # Path to your Google Cloud service account key file

VIEW_ID = ‘238782913’ # Your Google Analytics View ID

BIGQUERY_PROJECT = ‘Datenmigration’ # Your Google Cloud Project ID

BIGQUERY_DATASET = ‘UA_backfill’ # BigQuery Dataset name where the data will be stored

BIGQUERY_TABLE = ‘backfill’ # BigQuery Table name where the data will be stored

Du findest den Beitrag interessant? Neue Artikel im Newsletter erhalten.

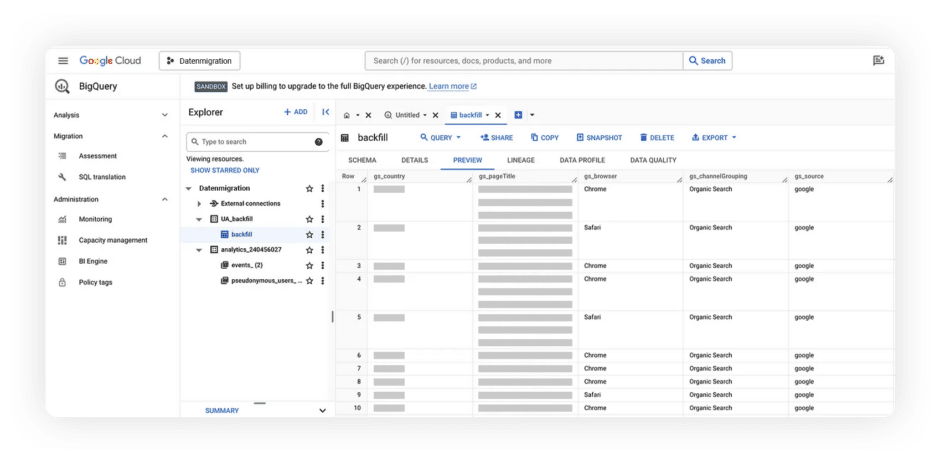

Schritt 6: Ausführen des Skripts

Nachdem du deine Konfiguration festgelegt hast, kannst du das Skript nun ausführen. Führe backfill-UA.py aus, und das Skript startet seinen Prozess:

- Initiieren der Verbindung: Das Skript beginnt mit dem Aufbau einer Verbindung zur Google Analytics Reporting API unter Verwendung der von dir angegebenen Anmeldeinformationen.

- Abrufen von Daten: Als Nächstes ruft es die erforderlichen Daten aus Universal Analytics ab, basierend auf den von dir angegebenen Metriken, Dimensionen und Datumsbereichen.

- Datenkonvertierung und Upload: Die Daten werden dann in ein mit BigQuery kompatibles Format konvertiert und anschließend in deine BigQuery-Tabelle hochgeladen.

Sobald das Skript seine Ausführung abgeschlossen hat, werden deine Universal Analytics-Daten sicher übertragen und in BigQuery gespeichert, so dass du sie bei Bedarf analysieren und nutzen kannst. Im Folgenden siehst du ein Beispiel dafür, wie die Ergebnisse aussehen:

Anpassen des Skripts für spezifische analytische Anforderungen

Feinabstimmung von Metriken und Dimensionen

Um den größtmöglichen Nutzen aus dem Skript zu ziehen, ist es wichtig, es an deine individuellen Analyseanforderungen anzupassen. Das bedeutet, dass du die Metriken und Dimensionen in der get_report Funktion so anpassen musst, dass sie mit deinen Analyseanforderungen übereinstimmen.

Erkunden von Metriken und Dimensionen

Innerhalb der get_report Funktion des Skripts findest du die Abschnitte für Metriken und Dimensionen. Dies sind im Wesentlichen die Kategorien und Datentypen, die du aus Universal Analytics abrufen möchtest. Betrachte Metriken als das „Was“ (wie Sitzungen, Seitenaufrufe, Benutzer) und Dimensionen als das „Wer“, „Wo“ und „Wie“ (wie Land, Browser, Seitentitel).

Nutzung der Dokumentation für Entscheidungen

Um fundierte Entscheidungen darüber zu treffen, welche Metriken und Dimensionen einbezogen werden sollen, kannst du die Dokumentation der Universal Analytics to GA4 Reporting API nutzen. Neben dem Artikel von Google kannst du auch unseren Blogartikel über den Vergleich von Google Universal mit Google Analytics 4 als Informationsquelle für die neuen Funktionen, Events und Möglichkeiten heranziehen.

Anpassungen in Aktion

Im Skript könnten die Abschnitte für Metriken und Dimensionen wie folgt aussehen:

'metrics': [

{'expression': 'ga:sessions'},

{'expression': 'ga:pageviews'},

# ... other metrics

],

'dimensions': [

{'name': 'ga:country'},

{'name': 'ga:pageTitle'},

# ... other dimensions

],

Hier hast du die Möglichkeit zur Anpassung. Um verschiedene Aspekte zu verfolgen, kannst du einfach Elemente in diesen Listen ersetzen oder hinzufügen.

Anpassen des Parameters „pageSize“

Der Parameter „pageSize“ am Ende der Funktion „get_report“ ist ebenfalls einstellbar. Er steuert, wie viele Datenzeilen du bei jeder Anfrage erhältst:

'pageSize': 20000 # Change as needed

Anpassen der Datumbereiche

Ein weiterer anpassbarer Aspekt ist der Abschnitt „dateRanges“. Die Standardeinstellung könnte sein:

'dateRanges': [{'startDate': '365daysAgo', 'endDate': 'today'}],

Du kannst die Werte „startDate“ und „endDate“ an den Zeitraum anpassen, den du analysieren möchtest.

Fazit: Datenumzug von Google Universal Analytics zu BigQuery

Bist ist du bereit, deine Daten von Universal Analytics auf BigQuery zu übertragen? Dieses Skript ist deine Geheimwaffe – einfach zu bedienen und an deine Bedürfnisse anpassbar. Falls immernoch etwas unklar sein sollte oder du beim Datenumzug auf Probleme stoßen solltest, dann komm gerne auf uns zu! Als zertifizierte Google-Partner Agentur stehen wir dir bei Fragen jederzeit zur Verfügung!

Als Content Creator und Copywriter sorgt Max dafür, dass im Content und Ads Bereich alles glatt läuft. Wenn er nicht gerade in WordPress unterwegs ist, dann unterstützt er fleißig bei der Erstellung von Performance Ads.